GateUser-a43bc48f

現在、コンテンツはありません

GateUser-a43bc48f

以前、複雑な分散型金融の戦略を作成するには、ブロックチェーンやプロトコルを理解し、コードを書く必要がありましたが、一般の人々にはまったく手が出せませんでした。しかし、@Infinit_Labs がすぐにオープンする「戦略生成」機能は、本当に面白いもので、基本的にこのハードルを平坦にしました。

彼らはベータテスト段階で1つの点を検証しました:自然言語でプロンプトを書けば、AIが自動的に一連の多段階の分散型金融戦略を生成してくれるということです。適当に書くのではなく、実際にブロックチェーン上で動作し、実行可能なものです。そしてこの機能は今後すべての人に開放されます。

これは何を意味するのか?信頼できる分散型金融のアイデアが頭の中にあれば、コードがわからなくても、論理を明確に説明できれば、AIに実行可能な戦略としてパッケージ化してもらうことができ、発表した後は他の人がそれを使い、あなたは収益を得ることができる。

このメカニズムはオープンな創作プラットフォームのように聞こえますが、DeFi戦略専用です。以前は他人のアイデアをコピーしたり、ホットなトピックを追いかけたりしていましたが、今は「理解できる限り、実現できる」ということです。これは、より多くの人々が戦略革新に参加することを奨励するだけでなく、正の循環を形成することもできます——コミュニティの中で実際に利益を生む戦略が現れることがあり

原文表示彼らはベータテスト段階で1つの点を検証しました:自然言語でプロンプトを書けば、AIが自動的に一連の多段階の分散型金融戦略を生成してくれるということです。適当に書くのではなく、実際にブロックチェーン上で動作し、実行可能なものです。そしてこの機能は今後すべての人に開放されます。

これは何を意味するのか?信頼できる分散型金融のアイデアが頭の中にあれば、コードがわからなくても、論理を明確に説明できれば、AIに実行可能な戦略としてパッケージ化してもらうことができ、発表した後は他の人がそれを使い、あなたは収益を得ることができる。

このメカニズムはオープンな創作プラットフォームのように聞こえますが、DeFi戦略専用です。以前は他人のアイデアをコピーしたり、ホットなトピックを追いかけたりしていましたが、今は「理解できる限り、実現できる」ということです。これは、より多くの人々が戦略革新に参加することを奨励するだけでなく、正の循環を形成することもできます——コミュニティの中で実際に利益を生む戦略が現れることがあり

- 報酬

- いいね

- コメント

- 共有

Meta @AIatMeta はまた成績で一つの事を証明しました:ソーシャル + AI、この組み合わせは本当に強力です。財務報告が出ると、純利益は直接大きな上昇を遂げ38%、株価は一晩で10%以上ポンプしました。この背後にある最も核心的な収入源は、やはり広告です。言い換えれば、AIツールを使って他人の顧客を引き寄せ、その結果自分たちが大きな利益を得るということです。

今、彼らはROIをAIを使って22%も向上させることができる。これはあまりにも熟練したコンビネーションだ。実際、これがWeb3版UXLINKが進んでいる道だ。ソーシャルは基盤であり、5400万人のユーザーのネットワーク効果は偽物ではあり得ない。AIはエンジンであり、Metaはこの方向に140億ドルを投入し、賭けを明確にしている。

さらに重要なのは、この市場自体が十分に大きいことです。世界の広告産業は毎年数千億の規模であり、Web3市場の年成長率は26.5%です。考えるだけで、これは長期的に大きな上昇の方向であることがわかります。

異なるのは、@UXLINKofficialが使用しているのは分散型ソーシャルネットワーク + 世界初のAI成長体XerpaAIであるということです。これはMetaの道を単にコピーするのではなく、Web3の方法で新しいルールを再構築しようとしているようです。Web3のMetaになることを目指して

今、彼らはROIをAIを使って22%も向上させることができる。これはあまりにも熟練したコンビネーションだ。実際、これがWeb3版UXLINKが進んでいる道だ。ソーシャルは基盤であり、5400万人のユーザーのネットワーク効果は偽物ではあり得ない。AIはエンジンであり、Metaはこの方向に140億ドルを投入し、賭けを明確にしている。

さらに重要なのは、この市場自体が十分に大きいことです。世界の広告産業は毎年数千億の規模であり、Web3市場の年成長率は26.5%です。考えるだけで、これは長期的に大きな上昇の方向であることがわかります。

異なるのは、@UXLINKofficialが使用しているのは分散型ソーシャルネットワーク + 世界初のAI成長体XerpaAIであるということです。これはMetaの道を単にコピーするのではなく、Web3の方法で新しいルールを再構築しようとしているようです。Web3のMetaになることを目指して

UXLINK-0.64%

- 報酬

- いいね

- コメント

- 共有

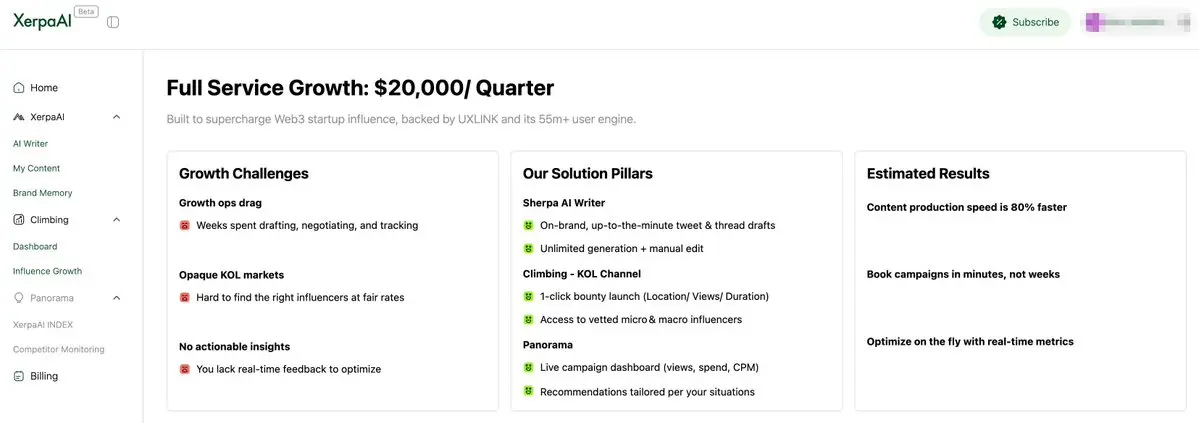

TrustaLabs は @XerpaAI の最初の四半期有料ユーザーとなり、@UXLINKofficial $UXLINK で支払いを行いました。取引はすべてブロックチェーンに記録され、透明性が最大化されています。

これは単なる協力ではなく、XerpaAI AGA(AI Growth Agent)モデルが市場に認められた信号のようです。Trustaが接続された後、Xerpaの全ての成長ツールを利用できるだけでなく、Influential Indexを活用してより正確なユーザー戦略を立てることができ、成長の問題をAIに任せることになりました。

さらに興味深いのは、UXLINK エコシステム内のプロジェクトであれば、$UXLINK で支払うと 10% 割引が受けられることです。公式は実際の行動でトークンに力を与えています。

私はこの種のコラボレーションが今後ますます増えると感じています。AIとソーシャルデータを組み合わせて成長を促進すること自体がWeb3において非常に希少な要素です。次はTrustaのデータがどのように動き出すか見ていきましょう。

原文表示これは単なる協力ではなく、XerpaAI AGA(AI Growth Agent)モデルが市場に認められた信号のようです。Trustaが接続された後、Xerpaの全ての成長ツールを利用できるだけでなく、Influential Indexを活用してより正確なユーザー戦略を立てることができ、成長の問題をAIに任せることになりました。

さらに興味深いのは、UXLINK エコシステム内のプロジェクトであれば、$UXLINK で支払うと 10% 割引が受けられることです。公式は実際の行動でトークンに力を与えています。

私はこの種のコラボレーションが今後ますます増えると感じています。AIとソーシャルデータを組み合わせて成長を促進すること自体がWeb3において非常に希少な要素です。次はTrustaのデータがどのように動き出すか見ていきましょう。

- 報酬

- いいね

- コメント

- 共有

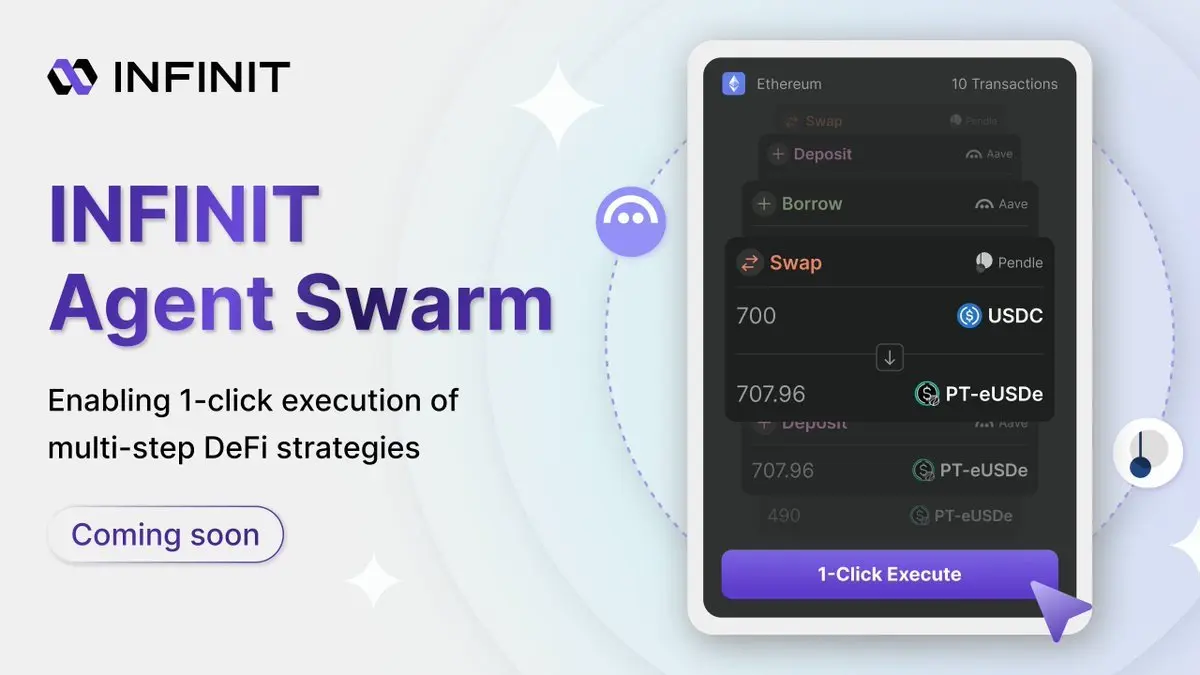

🥳 @Infinit_Labs V2 の今後のロードマップは、実際には「スマートアシスタント」から「実行エンジン」への重要な段階と言えます。全体のアップグレードは、3つの重点を中心に進められますが、第一歩は非常に注目すべきものです:ワンクリック実行。

現在ほとんどのDeFi操作はどこでつまずいているのか?それはあなたに戦略がないからではなく、単に動く気がないからです。たくさんのチェーン、たくさんのプロトコル、クロスチェーンは自分でブリッジを作らなければならず、バッチ操作も手動で何回もクリックしなければなりません。INFINITが提供するこのAgent Swarmは、この実行のハードルを解決するために特別に設計されています。

将来、戦略を見たときに、十数ステップを研究する必要はなく、ただクリックするだけで、複数のエージェントが自動的に調整して実行します:どうやってコインを交換するのか、どうやってクロスチェーンをするのか、どうやってポジションを分割したり統合したり、アービトラージをするのか、すべて自動です。最も重要なのは、資金を外に出す必要がなく、操作全体があなたのウォレット内で完了し、実行ロジックを事前に確認できるため、ブラックボックスに収穫されることを心配する必要がありません。

現在この機能はプライベートテスト段階で既に動いており、今後は徐々により多くのユーザーに開放される予定で

原文表示現在ほとんどのDeFi操作はどこでつまずいているのか?それはあなたに戦略がないからではなく、単に動く気がないからです。たくさんのチェーン、たくさんのプロトコル、クロスチェーンは自分でブリッジを作らなければならず、バッチ操作も手動で何回もクリックしなければなりません。INFINITが提供するこのAgent Swarmは、この実行のハードルを解決するために特別に設計されています。

将来、戦略を見たときに、十数ステップを研究する必要はなく、ただクリックするだけで、複数のエージェントが自動的に調整して実行します:どうやってコインを交換するのか、どうやってクロスチェーンをするのか、どうやってポジションを分割したり統合したり、アービトラージをするのか、すべて自動です。最も重要なのは、資金を外に出す必要がなく、操作全体があなたのウォレット内で完了し、実行ロジックを事前に確認できるため、ブラックボックスに収穫されることを心配する必要がありません。

現在この機能はプライベートテスト段階で既に動いており、今後は徐々により多くのユーザーに開放される予定で

- 報酬

- いいね

- コメント

- 共有

Hyperionは@Aptosメインネットに上线して以来、成長速度が確かに非常に速いです。TVLはすでに1.3億ドルを突破し、Aptosの分散型金融プロジェクトの中で直接トップ10にランクインしています。6月の月間出来高も世界のDEXの中で12位に入っており、ユーザーが実際に利用していて、しかもかなり活用していることを示しています。

背後の理由は実はそれほど複雑ではありません。今、多くの人が「速くて安い」チェーンを探しています。Aptos自体の性能は十分強力で、さらにHyperionのようなサポート施設が加わることで、組み合わせの感覚が生まれます。単なる通貨の交換だけでなく、Kofi FinanceやAmnis Financeのようなプロジェクトとも連携して、ステーキング、流動性、組み合わせ戦略などすべてをつなげて、一つのシステムに変わりました。

このようなプレイスタイルの利点は、さまざまなプラットフォームを行き来する必要がなく、1つの場所で多くの操作を完了できることです。ユーザーにとっては非常に便利で、プロトコルにとってもより早くトラフィックを引き寄せ、資本を集めることができます。

全体的に見て、Hyperion はもはや「新しい DEX」ではなく、Aptos 上で全体の分散型金融基盤を新しいレベルに引き上げました。今後、Aptos がさらに勢いを増すなら、Hyperion は最

原文表示背後の理由は実はそれほど複雑ではありません。今、多くの人が「速くて安い」チェーンを探しています。Aptos自体の性能は十分強力で、さらにHyperionのようなサポート施設が加わることで、組み合わせの感覚が生まれます。単なる通貨の交換だけでなく、Kofi FinanceやAmnis Financeのようなプロジェクトとも連携して、ステーキング、流動性、組み合わせ戦略などすべてをつなげて、一つのシステムに変わりました。

このようなプレイスタイルの利点は、さまざまなプラットフォームを行き来する必要がなく、1つの場所で多くの操作を完了できることです。ユーザーにとっては非常に便利で、プロトコルにとってもより早くトラフィックを引き寄せ、資本を集めることができます。

全体的に見て、Hyperion はもはや「新しい DEX」ではなく、Aptos 上で全体の分散型金融基盤を新しいレベルに引き上げました。今後、Aptos がさらに勢いを増すなら、Hyperion は最

- 報酬

- いいね

- コメント

- 共有

@TheoriqAI が提唱した「Agentic Economy」という概念を見て、本当に DeFi の基盤を徹底的に改造しようとしていると感じました。彼らが行っている Alpha Protocol は、特定のユーザー層にサービスを提供するだけでなく、全体的なロング協力の金融オペレーションシステムを構築しようとしています。

彼らの切り口もかなり賢い——今、プロジェクトがトークンを発行した後、どうやって分散型金融と結びつけるか分からないことが多いが、Alpha Protocolを使うことで新しい金融の遊び方を直接導入できる。例えば、流動性戦略、プロトコル間のスマートな連携、さらにはロングの間のクロスプロトコル協力などで、「トークンはあるがどう使っていいかわからない」プロジェクトを完全なエコシステムに引き込むことになる。

DeFiツールやマーケットシグナル分析のプロジェクトには、スペースがあります。彼らは自分のデータやモデルをTheoriqネットワークに接続し、シグナルを提供し、エージェントのパフォーマンスを向上させることができ、同時にマネタイズも可能です。この「使うほどに稼げる」メカニズムは、多くの専門サービスプロバイダーを引き付けるでしょう。

より重要なのは、資金提供者にとって、機関投資家であれ個人投資家であれ、Theoriq の「swarm」システムを使って戦略を自動的に実行でき

原文表示彼らの切り口もかなり賢い——今、プロジェクトがトークンを発行した後、どうやって分散型金融と結びつけるか分からないことが多いが、Alpha Protocolを使うことで新しい金融の遊び方を直接導入できる。例えば、流動性戦略、プロトコル間のスマートな連携、さらにはロングの間のクロスプロトコル協力などで、「トークンはあるがどう使っていいかわからない」プロジェクトを完全なエコシステムに引き込むことになる。

DeFiツールやマーケットシグナル分析のプロジェクトには、スペースがあります。彼らは自分のデータやモデルをTheoriqネットワークに接続し、シグナルを提供し、エージェントのパフォーマンスを向上させることができ、同時にマネタイズも可能です。この「使うほどに稼げる」メカニズムは、多くの専門サービスプロバイダーを引き付けるでしょう。

より重要なのは、資金提供者にとって、機関投資家であれ個人投資家であれ、Theoriq の「swarm」システムを使って戦略を自動的に実行でき

- 報酬

- いいね

- コメント

- 共有

😜 @TheoriqAI 最近の進展のペースは本当に早いですね、メインネットはもうすぐです。次の重要なステップは AlphaVaults の立ち上げです。これは、資金を AI エージェントに管理してもらい、大規模に自動操作するということです。

第一波接入は、Arrakisと協力し、Uniswap v4のサポートを統合することで、AlphaSwarmの実戦段階を正式に開始することになります。

2025年Q3のメインネットの立ち上げまでの間、核心的な方向性はすでに明確です:SDKのリリース、金庫の立ち上げ、収益戦略の統合、さらに多くの第三者エージェントの接続です。実際、各ステップは資金管理を「人がする」から「AIが自動で行う」へと徐々に移行させる道を築いており、より正確で高効率です。

初期の純粋に手動でDeFiを楽しむプレイは確かに価値があるが、より基盤を作るようなものだ。本当のゴールは、ブロックチェーン上のエージェントが自動的に意思決定を行い、自動的にポートフォリオを調整し、自動的に再投資を行うことであり、一般のユーザーは目標を設定するだけで資産管理を実現できる。

Theoriq がやりたいことは、要するにこれらの「AIによる資金管理」の未来のためのインフラを整備することです。彼らはトレンドが来るのを待つのではなく、直接手を動かして軌道を敷いています。もし agent という方向に

原文表示第一波接入は、Arrakisと協力し、Uniswap v4のサポートを統合することで、AlphaSwarmの実戦段階を正式に開始することになります。

2025年Q3のメインネットの立ち上げまでの間、核心的な方向性はすでに明確です:SDKのリリース、金庫の立ち上げ、収益戦略の統合、さらに多くの第三者エージェントの接続です。実際、各ステップは資金管理を「人がする」から「AIが自動で行う」へと徐々に移行させる道を築いており、より正確で高効率です。

初期の純粋に手動でDeFiを楽しむプレイは確かに価値があるが、より基盤を作るようなものだ。本当のゴールは、ブロックチェーン上のエージェントが自動的に意思決定を行い、自動的にポートフォリオを調整し、自動的に再投資を行うことであり、一般のユーザーは目標を設定するだけで資産管理を実現できる。

Theoriq がやりたいことは、要するにこれらの「AIによる資金管理」の未来のためのインフラを整備することです。彼らはトレンドが来るのを待つのではなく、直接手を動かして軌道を敷いています。もし agent という方向に

- 報酬

- いいね

- コメント

- 共有

😜 @Aptos この波のRWAは本当に色鮮やかで、「未来に可能性がある」だけではなく、実際にトラッドファイ資産をオンチェーンに移してきました。今、オンチェーンでは十数種類のRWA製品が展開されており、その背後にはWeb3プロジェクトだけでなく、BlackRockやFranklin Templetonのようなトラッドファイの巨頭も直接参加しています。

PACT Protocolは、内部で比較的コアなプロジェクトで、主にオンチェーンでの債券発行や貸付を主眼にしています。現在、オンチェーンの資産規模は3億ドルを超えており、最近8000万ドルが追加されました。トラッドファイの一連の貸付、パッケージ化、証券発行のプロセスを、Aptosに移行したと考えることができます。

さらに面白いことに、あなたがcryptoと交わることは不可能だと思っていた機関が本当に来ました。例えば、BlackRockが発行したBUIDLは、世界で最も資産規模の大きいオンチェーンファンドであり、Franklin TempletonのBENJIは規模が大きいだけでなく、直接ブロックチェーンを使って取引を処理しています。このような形で、オフチェーンとオンチェーンのデータの流れが完全に統合されています。

また、LibreやOndoのようなプロジェクトは、安定した収益を得られるドル資産、プライベート債、マネーマーケットファン

原文表示PACT Protocolは、内部で比較的コアなプロジェクトで、主にオンチェーンでの債券発行や貸付を主眼にしています。現在、オンチェーンの資産規模は3億ドルを超えており、最近8000万ドルが追加されました。トラッドファイの一連の貸付、パッケージ化、証券発行のプロセスを、Aptosに移行したと考えることができます。

さらに面白いことに、あなたがcryptoと交わることは不可能だと思っていた機関が本当に来ました。例えば、BlackRockが発行したBUIDLは、世界で最も資産規模の大きいオンチェーンファンドであり、Franklin TempletonのBENJIは規模が大きいだけでなく、直接ブロックチェーンを使って取引を処理しています。このような形で、オフチェーンとオンチェーンのデータの流れが完全に統合されています。

また、LibreやOndoのようなプロジェクトは、安定した収益を得られるドル資産、プライベート債、マネーマーケットファン

- 報酬

- いいね

- コメント

- 共有

🧐 @burnt_xion 最近韓国の経済テレビで大々的に登場し、その背後には実はより大きな戦略的意図が示されています——APAC市場への全面進出。

創設者 Burnt Banksy は明確に述べました。今回は単なる市場プロモーションではなく、数ヶ月にわたる APAC アクションプランを開始します。彼が米国株市場で活動していたことから、今やアジアに重点を置くようになったことは、XION が本当にアジア太平洋地域の土壌を借りて「暗号を消す」という理念を現実のものにしたいと考えていることを示しています。

実際、理解するのはそれほど難しくありません。APACは新技術の実験場であり、サムスンや現代自動車、中国のインフラやデジタル決済に至るまで、ここにいるユーザーは最先端の技術を受け入れやすいです。そして、Web3分野では、ここが世界のユーザーの3分の2を占めており、一部の国では暗号資産の保有率が4分の1に達しています。

XIONはWeb3を「Web2のように簡単に」実現したいと考えていますが、それはユーザーの習慣と文化から出発しなければなりません。アジアはちょうどこの互換性を備えており、新しい技術を受け入れながら、実際の応用価値を追求しています。これはXIONの理念と非常に合致しています。

今、彼らはユーザーを引き付けるだけでなく、ブランド、開発者、コンテンツクリエイターも引き付けて、エ

原文表示創設者 Burnt Banksy は明確に述べました。今回は単なる市場プロモーションではなく、数ヶ月にわたる APAC アクションプランを開始します。彼が米国株市場で活動していたことから、今やアジアに重点を置くようになったことは、XION が本当にアジア太平洋地域の土壌を借りて「暗号を消す」という理念を現実のものにしたいと考えていることを示しています。

実際、理解するのはそれほど難しくありません。APACは新技術の実験場であり、サムスンや現代自動車、中国のインフラやデジタル決済に至るまで、ここにいるユーザーは最先端の技術を受け入れやすいです。そして、Web3分野では、ここが世界のユーザーの3分の2を占めており、一部の国では暗号資産の保有率が4分の1に達しています。

XIONはWeb3を「Web2のように簡単に」実現したいと考えていますが、それはユーザーの習慣と文化から出発しなければなりません。アジアはちょうどこの互換性を備えており、新しい技術を受け入れながら、実際の応用価値を追求しています。これはXIONの理念と非常に合致しています。

今、彼らはユーザーを引き付けるだけでなく、ブランド、開発者、コンテンツクリエイターも引き付けて、エ

- 報酬

- いいね

- コメント

- 共有

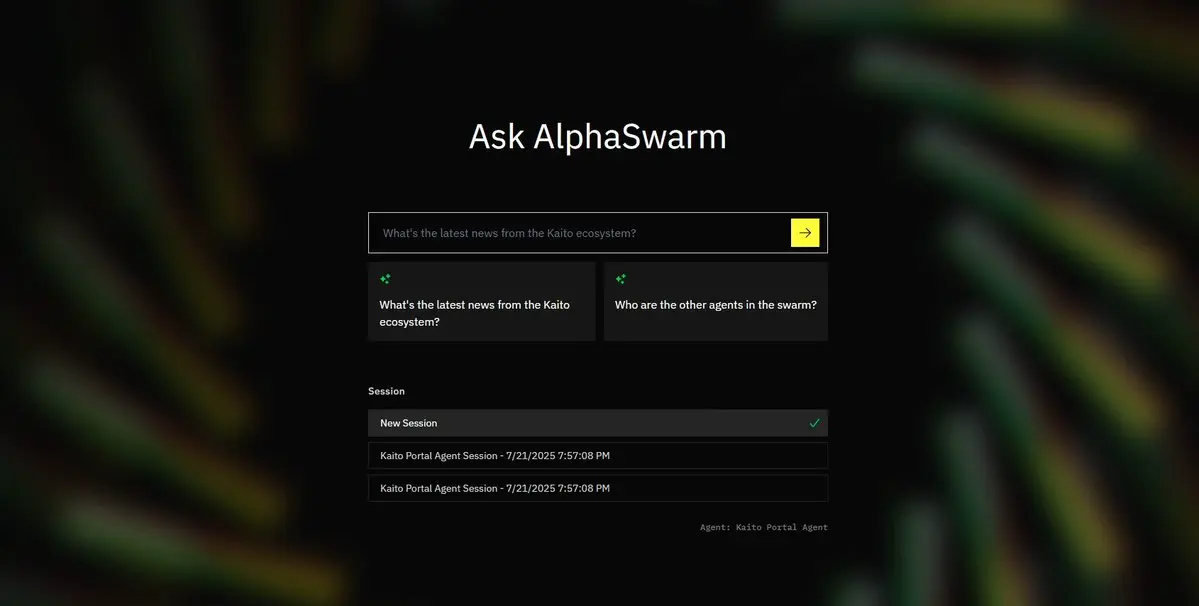

🫡 @TheoriqAI は @KaitoAI の Capital Launchpad でコミュニティラウンドを開始し、$THQ のサブスクリプション機会を事前に公開しました。このラウンドは Pre-TGE フェーズで、公式が初めてユーザー向けにトークン通路を公開したものです。また、7500 万の評価額、TGE 全解放で、超過募集は40倍、熱度は直接ポンプされました!!!

今回の計画はとても細かく、全体のプロセスは3つのステップに分かれています。最初は「予約枠」、次は「優先サブスクリプション」、最後は「先着順」です。第一段階では、定金をロックして、どれだけのトークンを取得したいかを示す必要があります。第二段階では、公式からメールが届き、取得できたかどうかが通知されます。第三段階はスピード勝負で、枠を取得できなかったユーザーはチャンスを狙うことができます。

大部分の人にとって、重要なのは今回の参加のハードルがそれほど高くないことです。Baseチェーン上でUSDCをプラージュするだけで大丈夫で、操作も複雑ではありません。このラウンドには追加の特典も付いています——参加するだけでAlphaSwarmのベータ版を事前に使用できるため、Theoriqのコア製品を事前に体験することができます。

実際、Theoriqの以前の一連の配置から見ると、彼らがエージェンティックエコノミーを行うのは計画

原文表示今回の計画はとても細かく、全体のプロセスは3つのステップに分かれています。最初は「予約枠」、次は「優先サブスクリプション」、最後は「先着順」です。第一段階では、定金をロックして、どれだけのトークンを取得したいかを示す必要があります。第二段階では、公式からメールが届き、取得できたかどうかが通知されます。第三段階はスピード勝負で、枠を取得できなかったユーザーはチャンスを狙うことができます。

大部分の人にとって、重要なのは今回の参加のハードルがそれほど高くないことです。Baseチェーン上でUSDCをプラージュするだけで大丈夫で、操作も複雑ではありません。このラウンドには追加の特典も付いています——参加するだけでAlphaSwarmのベータ版を事前に使用できるため、Theoriqのコア製品を事前に体験することができます。

実際、Theoriqの以前の一連の配置から見ると、彼らがエージェンティックエコノミーを行うのは計画

- 報酬

- いいね

- コメント

- 共有

🫡 @Mira_Network 新しいアプローチで打開策を見つけたい——AIに自分で決めさせるのではなく、AIの「上層」に立って、AIが言うことが本当に正しいかどうかを専門的に検証するシステムを構築する方が良い。現在、皆がAIがどれだけ強気かを語っているが、実際に実現可能なシナリオは非常に限られている。

結局のところ、AIの現在最大の問題は「信頼性がない」ということです——それは見た目には非常に論理的な内容を書くことができるが、一度詳しく見ると、しばしば偽の情報が混じっていることがわかります。この問題はチャットボットではまだ許容されますが、医療、法律、金融などの高リスクなシナリオに応用されると、まったく問題になります。

AIはなぜこうなるのか?核心的な理由の一つは、「正確性」と「安定性」の間で常に両立できないからです。出力をより安定させたい場合は、トレーニングデータをよりクリーンに収集する必要がありますが、その結果、バイアスが持ち込まれやすくなります。逆に、より現実世界に近づけ、より包括的にカバーしたい場合は、多くの対立する情報を入れる必要があり、モデルは逆に「信頼できない発言」をするようになり、つまり幻覚を起こしやすくなります。

この方法は、AIに「事実確認者」を装着するようなものです。AIが最初にコンテンツを出力し、Miraがその内容をいくつかの小さな判断に分解し、複数の独立

原文表示結局のところ、AIの現在最大の問題は「信頼性がない」ということです——それは見た目には非常に論理的な内容を書くことができるが、一度詳しく見ると、しばしば偽の情報が混じっていることがわかります。この問題はチャットボットではまだ許容されますが、医療、法律、金融などの高リスクなシナリオに応用されると、まったく問題になります。

AIはなぜこうなるのか?核心的な理由の一つは、「正確性」と「安定性」の間で常に両立できないからです。出力をより安定させたい場合は、トレーニングデータをよりクリーンに収集する必要がありますが、その結果、バイアスが持ち込まれやすくなります。逆に、より現実世界に近づけ、より包括的にカバーしたい場合は、多くの対立する情報を入れる必要があり、モデルは逆に「信頼できない発言」をするようになり、つまり幻覚を起こしやすくなります。

この方法は、AIに「事実確認者」を装着するようなものです。AIが最初にコンテンツを出力し、Miraがその内容をいくつかの小さな判断に分解し、複数の独立

- 報酬

- いいね

- コメント

- 共有