GateUser-a43bc48f

用戶暫無簡介

GateUser-a43bc48f

以前做一套復雜的 DeFi 策略,要懂鏈、懂協議、會寫代碼,普通人根本玩不來。但 @Infinit_Labs 馬上要開放的“策略生成”功能,真的有點意思,它基本把這個門檻打平了。

他們在內測階段就驗證了一個點:用自然語言寫提示語,AI 就能幫你自動生成一整套多步驟的 DeFi 策略。不是隨便寫寫,而是能真正在鏈上跑起來、還能被執行的那種。而接下來,這個功能會向所有人開放。

意味着什麼?只要你腦子裏有個靠譜的 DeFi 想法,哪怕你不懂代碼,只要你能把邏輯講清楚,就能讓 AI 幫你打包成可執行的策略,發出來之後別人用,你還能賺收益。

這個機制聽起來有點像開放式創作平台,但是專爲 DeFi 策略服務的。比起以前靠抄別人思路或者追熱點,現在是“只要你能想得明白,就能做出來”。這不光能鼓勵更多人參與策略創新,還能形成一種正循環——社區裏真的會冒出一些實打實能賺錢的策略,不靠炒作,靠的是創意和執行力。

我覺得它本質上是把 DeFi 從“拼技術”變成了“拼創意和表達”,這對整個圈子的影響可能比我們想象的大。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon 熱度也很高

查看原文他們在內測階段就驗證了一個點:用自然語言寫提示語,AI 就能幫你自動生成一整套多步驟的 DeFi 策略。不是隨便寫寫,而是能真正在鏈上跑起來、還能被執行的那種。而接下來,這個功能會向所有人開放。

意味着什麼?只要你腦子裏有個靠譜的 DeFi 想法,哪怕你不懂代碼,只要你能把邏輯講清楚,就能讓 AI 幫你打包成可執行的策略,發出來之後別人用,你還能賺收益。

這個機制聽起來有點像開放式創作平台,但是專爲 DeFi 策略服務的。比起以前靠抄別人思路或者追熱點,現在是“只要你能想得明白,就能做出來”。這不光能鼓勵更多人參與策略創新,還能形成一種正循環——社區裏真的會冒出一些實打實能賺錢的策略,不靠炒作,靠的是創意和執行力。

我覺得它本質上是把 DeFi 從“拼技術”變成了“拼創意和表達”,這對整個圈子的影響可能比我們想象的大。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon 熱度也很高

- 讚賞

- 點讚

- 留言

- 分享

Meta @AIatMeta 又用成績證明了一件事:社交+AI,這個組合真的太能打了。財報一出來,淨利潤直接暴漲38%,股價一個晚上拉了10%以上。這背後最核心的收入來源,還是廣告。說白了,就是靠 AI 工具幫別人拉客戶,然後自己賺得盆滿鉢滿。

現在他們連 ROI 都能通過 AI 提高 22%,這套組合拳也太熟練了。而這,其實就是 Web3 版 UXLINK 正在走的路。社交是底子,5400萬用戶的網路效應不可能是假的;AI 是引擎,Meta 爲了這個方向都砸了140億美元,下注壓得明明白白。

更關鍵的是,這個市場本身夠大。全球廣告產業每年幾千億的體量,再加上 Web3 市場 26.5% 的年增長率,光想想就知道這是個長期爆發的方向。

不同的是, @UXLINKofficial 用的是去中心化社交關係網 + 世界第一個 AI 增長體 XerpaAI。這不只是復制 Meta 的路,更像是在用 Web3 的方式重構一套新規則。不是要成爲 Web3 的 Meta,而是幹脆超越它。

現在他們連 ROI 都能通過 AI 提高 22%,這套組合拳也太熟練了。而這,其實就是 Web3 版 UXLINK 正在走的路。社交是底子,5400萬用戶的網路效應不可能是假的;AI 是引擎,Meta 爲了這個方向都砸了140億美元,下注壓得明明白白。

更關鍵的是,這個市場本身夠大。全球廣告產業每年幾千億的體量,再加上 Web3 市場 26.5% 的年增長率,光想想就知道這是個長期爆發的方向。

不同的是, @UXLINKofficial 用的是去中心化社交關係網 + 世界第一個 AI 增長體 XerpaAI。這不只是復制 Meta 的路,更像是在用 Web3 的方式重構一套新規則。不是要成爲 Web3 的 Meta,而是幹脆超越它。

UXLINK0.43%

- 讚賞

- 點讚

- 留言

- 分享

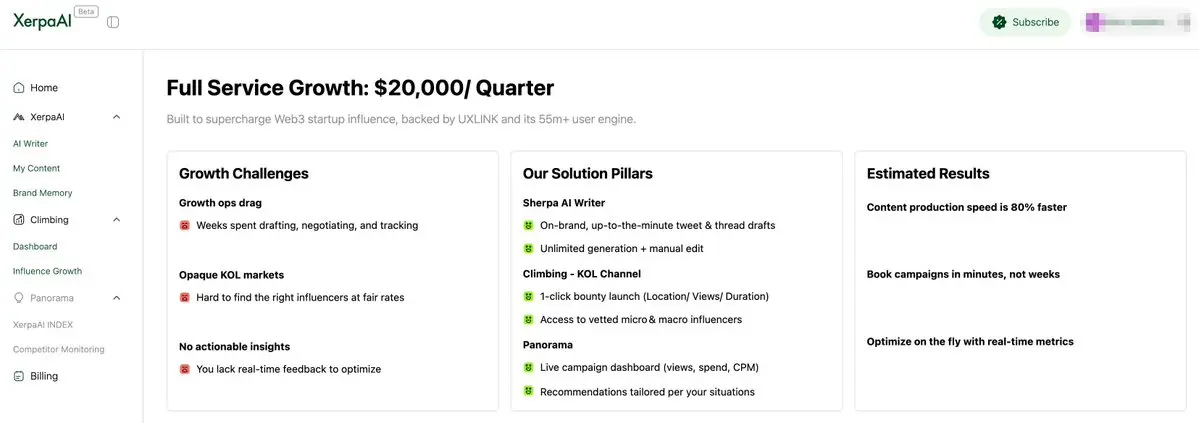

TrustaLabs 成爲 @XerpaAI 的首個季度付費用戶了,而且用的是 @UXLINKofficial $UXLINK 付款,交易都上鏈了,透明度拉滿。

這不光是一個合作,更像是 XerpaAI AGA(AI Growth Agent)模式被市場認可的信號。Trusta 接入後,不僅能用上 Xerpa 的全套增長工具,還能利用 Influential Index 做更精準的用戶策略,等於是把增長這事交給了 AI 來搞定。

更有意思的是,只要是 UXLINK 生態內的項目,用 $UXLINK 支付還能打九折,官方是真的在用實際動作給代幣賦能。

我感覺這類合作未來只會越來越多,AI 和社交數據結合搞增長,本身就是 Web3 很稀缺的一環。接下來就看 Trusta 的數據怎麼跑起來了。

查看原文這不光是一個合作,更像是 XerpaAI AGA(AI Growth Agent)模式被市場認可的信號。Trusta 接入後,不僅能用上 Xerpa 的全套增長工具,還能利用 Influential Index 做更精準的用戶策略,等於是把增長這事交給了 AI 來搞定。

更有意思的是,只要是 UXLINK 生態內的項目,用 $UXLINK 支付還能打九折,官方是真的在用實際動作給代幣賦能。

我感覺這類合作未來只會越來越多,AI 和社交數據結合搞增長,本身就是 Web3 很稀缺的一環。接下來就看 Trusta 的數據怎麼跑起來了。

- 讚賞

- 點讚

- 留言

- 分享

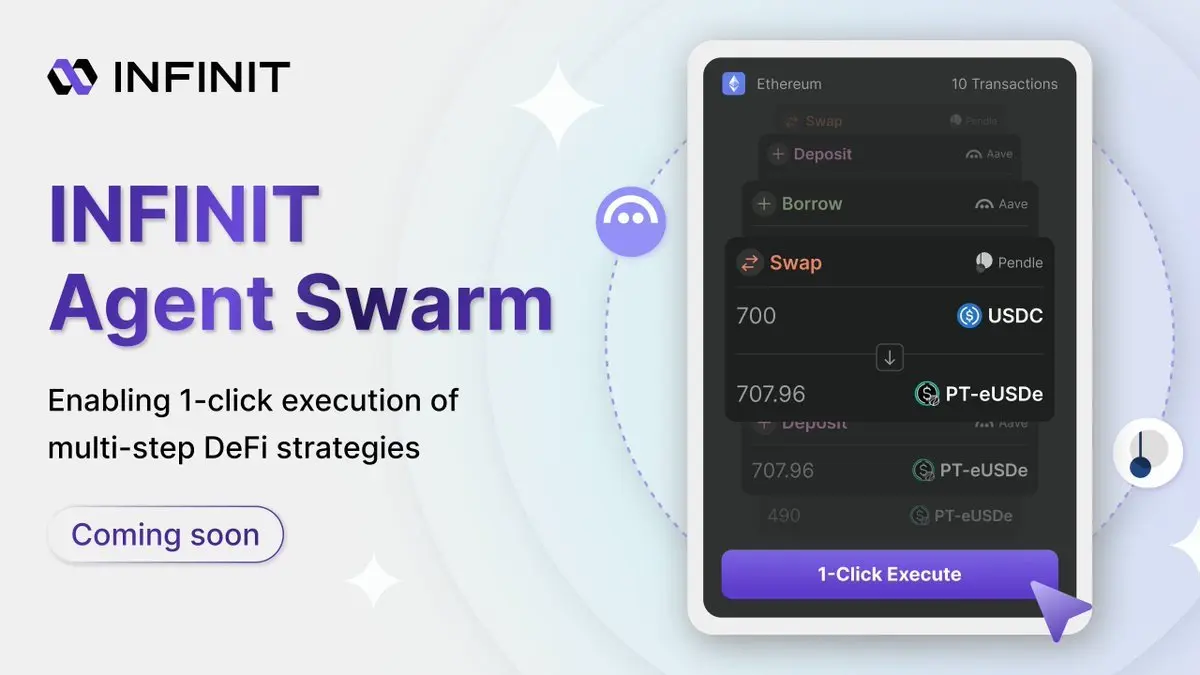

🥳 @Infinit_Labs V2 接下來的路線圖,其實可以說是它從“智能助手”變成“執行引擎”的關鍵階段。整個升級是圍繞三個重點來推進的,但第一步就很有看頭:一鍵執行。

現在大部分 DeFi 操作卡在哪?不是你沒策略,是根本懶得動手。一堆鏈、一堆協議,跨鏈還得自己橋,批操作都要手動點好幾次。INFINIT 搞的這個 Agent Swarm,就是專門解決這個執行門檻的。

未來你看到一個策略,不用研究十幾步,只要點一下,底層多個 Agent 會自己協調執行:怎麼換幣,怎麼跨鏈,怎麼拆倉、合倉、套利,全自動。最關鍵的是資金不需要交出去,操作全程都在你的錢包內完成,還能事前看清楚執行邏輯,不怕被黑箱子收割。

目前這個功能在私測階段就已經跑過,接下來會逐步開放給更多用戶。如果你是那種經常覺得“策略都看懂了,就是懶得操作”的人,INFINIT 這一波可能會讓你重新回到鏈上玩起來。

對我來說,這種體驗就像是 DeFi 終於有了自己的“支付寶”——復雜操作都藏在後臺,你只管點擊,執行這事以後不需要你操心了。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon 熱度也很高

查看原文現在大部分 DeFi 操作卡在哪?不是你沒策略,是根本懶得動手。一堆鏈、一堆協議,跨鏈還得自己橋,批操作都要手動點好幾次。INFINIT 搞的這個 Agent Swarm,就是專門解決這個執行門檻的。

未來你看到一個策略,不用研究十幾步,只要點一下,底層多個 Agent 會自己協調執行:怎麼換幣,怎麼跨鏈,怎麼拆倉、合倉、套利,全自動。最關鍵的是資金不需要交出去,操作全程都在你的錢包內完成,還能事前看清楚執行邏輯,不怕被黑箱子收割。

目前這個功能在私測階段就已經跑過,接下來會逐步開放給更多用戶。如果你是那種經常覺得“策略都看懂了,就是懶得操作”的人,INFINIT 這一波可能會讓你重新回到鏈上玩起來。

對我來說,這種體驗就像是 DeFi 終於有了自己的“支付寶”——復雜操作都藏在後臺,你只管點擊,執行這事以後不需要你操心了。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon 熱度也很高

- 讚賞

- 點讚

- 留言

- 分享

Hyperion 自從上線 @Aptos 主網之後,發展速度確實挺猛的。TVL 已經破了 1.3 億美金,在 Aptos 的 DeFi 項目裏直接衝進前十,六月的月交易量也排進全球 DEX 前十二,說明用戶是真在用,而且用得挺重的。

背後原因其實也不復雜。現在很多人都在找“又快又便宜”的鏈,Aptos 本身的性能已經夠強,再加上 Hyperion 這種配套設施,就有了組合拳的感覺。不光是換幣這件事兒,它還跟像 Kofi Finance、Amnis Finance 這類項目打通了,把質押、流動性、組合策略這些全都接起來了,變成一整個系統。

這種玩法的好處是你不用在各個平台來回跳,一個地方就能完成比較多操作。對用戶來說很省心,對協議來說也能更快吸流量、聚資本。

整體來看,Hyperion 已經不只是一個“新 DEX”,而是在 Aptos 上把整個 DeFi 基建拉上了一個新臺階。後續如果 Aptos 繼續漲聲勢,那 Hyperion 很可能就是那個最先喫到紅利的玩家之一。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @0xPolygon 熱度也很高

查看原文背後原因其實也不復雜。現在很多人都在找“又快又便宜”的鏈,Aptos 本身的性能已經夠強,再加上 Hyperion 這種配套設施,就有了組合拳的感覺。不光是換幣這件事兒,它還跟像 Kofi Finance、Amnis Finance 這類項目打通了,把質押、流動性、組合策略這些全都接起來了,變成一整個系統。

這種玩法的好處是你不用在各個平台來回跳,一個地方就能完成比較多操作。對用戶來說很省心,對協議來說也能更快吸流量、聚資本。

整體來看,Hyperion 已經不只是一個“新 DEX”,而是在 Aptos 上把整個 DeFi 基建拉上了一個新臺階。後續如果 Aptos 繼續漲聲勢,那 Hyperion 很可能就是那個最先喫到紅利的玩家之一。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @0xPolygon 熱度也很高

- 讚賞

- 點讚

- 留言

- 分享

看到 @TheoriqAI 提出的“Agentic Economy”這個概念,感覺是真的想把 DeFi 底層做徹底改造。他們做的 Alpha Protocol,不只是給某類用戶服務,而是想搭一整套多方協作的金融操作系統。

他們的切入點也挺聰明——現在項目發幣之後,經常不知道怎麼和 DeFi 結合,用 Alpha Protocol 就可以直接引入新型金融玩法,比如流動性策略、協議間的智能配合、甚至是多智能體之間的跨協議協作,等於是把“有幣但不知道怎麼玩”的項目引進一個完整生態。

對於那些做 DeFi 工具或者市場信號分析的項目,也有空間。他們可以把自己的數據或模型接入 Theoriq 網路,提供信號、提高 agent 表現,同時還能變現。這種“邊用邊賺”的機制,會吸引不少專業服務商入場。

更關鍵的是,對於資金方來說,不管是機構還是個體投資者,都可以用 Theoriq 的“swarm”系統來自動執行策略。特別在市場行情變動快的時候,全自動調倉、控制風險、抓機會,這種能力就很值錢。

最後,Theoriq 也沒忘開發者。如果你能開發一個收益策略的 agent,不但可以上鏈運行、還可以通過表現獲得收益激勵。這種開放系統,搞不好會激發出一批新的智能體創業者。

整體看下來,Theoriq 這個體系像是要重構整個 DeFi 的邏輯。不是做一個協議,而是創造一套“智能體+協作+策略”的全鏈式生態。

查看原文他們的切入點也挺聰明——現在項目發幣之後,經常不知道怎麼和 DeFi 結合,用 Alpha Protocol 就可以直接引入新型金融玩法,比如流動性策略、協議間的智能配合、甚至是多智能體之間的跨協議協作,等於是把“有幣但不知道怎麼玩”的項目引進一個完整生態。

對於那些做 DeFi 工具或者市場信號分析的項目,也有空間。他們可以把自己的數據或模型接入 Theoriq 網路,提供信號、提高 agent 表現,同時還能變現。這種“邊用邊賺”的機制,會吸引不少專業服務商入場。

更關鍵的是,對於資金方來說,不管是機構還是個體投資者,都可以用 Theoriq 的“swarm”系統來自動執行策略。特別在市場行情變動快的時候,全自動調倉、控制風險、抓機會,這種能力就很值錢。

最後,Theoriq 也沒忘開發者。如果你能開發一個收益策略的 agent,不但可以上鏈運行、還可以通過表現獲得收益激勵。這種開放系統,搞不好會激發出一批新的智能體創業者。

整體看下來,Theoriq 這個體系像是要重構整個 DeFi 的邏輯。不是做一個協議,而是創造一套“智能體+協作+策略”的全鏈式生態。

- 讚賞

- 點讚

- 留言

- 分享

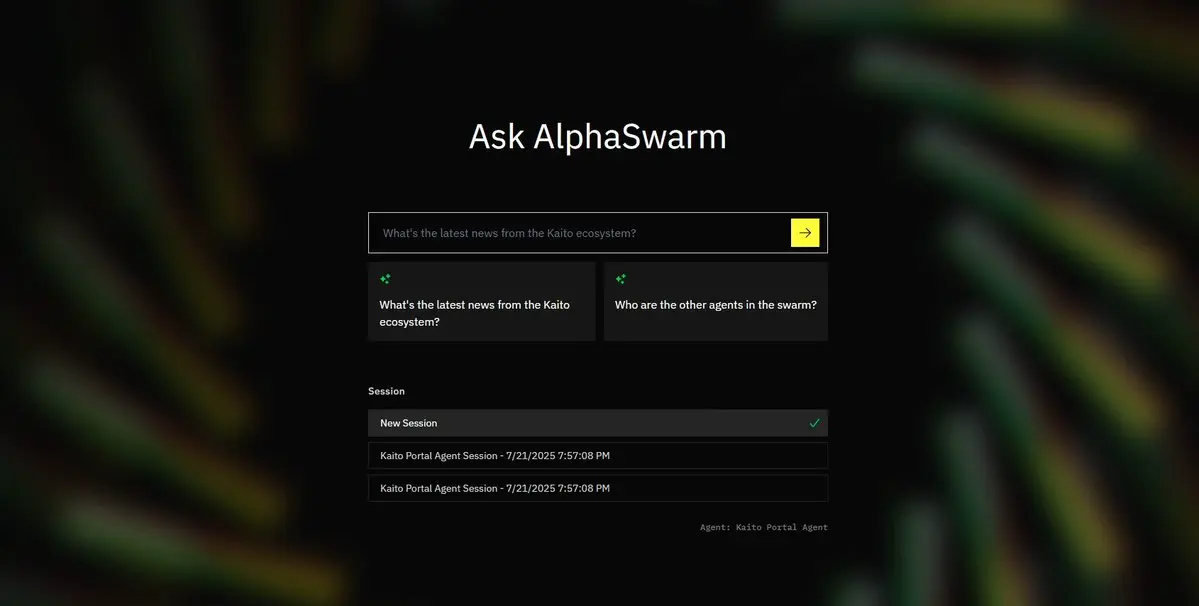

😜 @TheoriqAI 最近的進展節奏是真的快,主網已經在路上了,接下來關鍵的一步是 AlphaVaults 的上線。這一塊其實就是把資金交給 AI agent 管理,而且是規模化地自動操作。

第一波接入,會和 Arrakis 合作,把 Uniswap v4 的支持集成進來,也算是正式開啓 AlphaSwarm 的實戰階段。

從現在到 2025 年 Q3 主網上線,核心方向已經很清晰:SDK 放出、金庫上線、收益策略集成,以及更多第三方 agent 的接入。每一步其實都在鋪一條路,讓資金管理這件事慢慢從“人做”變成“AI 自動跑”,而且更精準、更高效。

早期那種純手動擼 DeFi 的玩法肯定是有價值的,但更像是打基礎。真正的終點應該是鏈上的 agent 自動做決策、自動調倉、自動復投,普通用戶只需要設定目標,就能實現財富管理。

Theoriq 想做的事情,說白了就是給這些“AI 管理資金”的未來打基礎設施。他們不是等着趨勢來了再跟風,而是直接上手把軌道鋪出來。如果你對 agent 這個方向感興趣,後面這波主網上線的進展值得重點盯住。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon @shoutdotfun $ENERGY 熱度也很高

查看原文第一波接入,會和 Arrakis 合作,把 Uniswap v4 的支持集成進來,也算是正式開啓 AlphaSwarm 的實戰階段。

從現在到 2025 年 Q3 主網上線,核心方向已經很清晰:SDK 放出、金庫上線、收益策略集成,以及更多第三方 agent 的接入。每一步其實都在鋪一條路,讓資金管理這件事慢慢從“人做”變成“AI 自動跑”,而且更精準、更高效。

早期那種純手動擼 DeFi 的玩法肯定是有價值的,但更像是打基礎。真正的終點應該是鏈上的 agent 自動做決策、自動調倉、自動復投,普通用戶只需要設定目標,就能實現財富管理。

Theoriq 想做的事情,說白了就是給這些“AI 管理資金”的未來打基礎設施。他們不是等着趨勢來了再跟風,而是直接上手把軌道鋪出來。如果你對 agent 這個方向感興趣,後面這波主網上線的進展值得重點盯住。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon @shoutdotfun $ENERGY 熱度也很高

- 讚賞

- 點讚

- 留言

- 分享

😜 @Aptos 這波 RWA 做得是真有聲有色,已經不只是“未來有潛力”了,而是實打實地把傳統金融資產搬上鏈了。現在鏈上已經上線了十幾種 RWA 產品,背後不光有 Web3 項目,也有像 BlackRock 和 Franklin Templeton 這種傳統金融巨頭直接參與。

PACT Protocol 是裏頭比較核心的項目,主打就是鏈上發債、發貸款那一套,現在鏈上的資產規模已經超過 3 億美金了,最近又剛加了 8000 萬。可以理解爲把傳統金融裏的一整套貸款、打包、發證券的流程,都搬到了 Aptos 上。

更有意思的是,那些你以爲不可能和 crypto 有交集的機構,也真的來了。比如 BlackRock 發的 BUIDL 是全球資產規模最大的鏈上基金,Franklin Templeton 的 BENJI 不僅規模大,而且直接用區塊鏈來處理交易,這種根本就是打通了鏈下鏈上的數據流動。

另外像 Libre、Ondo 這種項目,也在補充更多細分的需求,比如穩定收益的美元資產、私募債、貨幣基金等。這些不是靠空投吸人,而是真有人想要用,背後代表的是一批合規的錢在往鏈上靠。

說到底,這不是哪家項目漲不漲的問題,而是 Aptos 在用一套更強的技術底座,把整個鏈上的金融資產生態做大。後面 RWA 的機會,可能不在敘事本身,而是誰能把這些資產打包成新的玩法,讓傳統的錢也願意留下來。

關鍵是

查看原文PACT Protocol 是裏頭比較核心的項目,主打就是鏈上發債、發貸款那一套,現在鏈上的資產規模已經超過 3 億美金了,最近又剛加了 8000 萬。可以理解爲把傳統金融裏的一整套貸款、打包、發證券的流程,都搬到了 Aptos 上。

更有意思的是,那些你以爲不可能和 crypto 有交集的機構,也真的來了。比如 BlackRock 發的 BUIDL 是全球資產規模最大的鏈上基金,Franklin Templeton 的 BENJI 不僅規模大,而且直接用區塊鏈來處理交易,這種根本就是打通了鏈下鏈上的數據流動。

另外像 Libre、Ondo 這種項目,也在補充更多細分的需求,比如穩定收益的美元資產、私募債、貨幣基金等。這些不是靠空投吸人,而是真有人想要用,背後代表的是一批合規的錢在往鏈上靠。

說到底,這不是哪家項目漲不漲的問題,而是 Aptos 在用一套更強的技術底座,把整個鏈上的金融資產生態做大。後面 RWA 的機會,可能不在敘事本身,而是誰能把這些資產打包成新的玩法,讓傳統的錢也願意留下來。

關鍵是

- 讚賞

- 點讚

- 留言

- 分享

🧐 @burnt_xion 最近在韓國財經電視上高調亮相,背後其實透露了一個更大的戰略意圖——全面進軍 APAC 市場。

創始人 Burnt Banksy 明確講了,這次不是簡單地做市場推廣,而是開啓一場多月的 APAC 行動計劃。從他在美股圈的活躍,到現在將重心轉向亞洲,說明 XION 真的是想借亞太這片土壤,把“讓加密消失”這個理念落地爲現實。

其實也不難理解。APAC 早就是新技術的試驗場,從三星、現代,到中國的基建和數字支付,這裏的用戶本身就更容易接受前沿科技。而在 Web3 領域,這裏更是佔了全球用戶的三分之二,有些國家加密持有率高達四分之一。

XION 想把 Web3 做到“像 Web2 一樣簡單”,那一定要從用戶習慣和文化出發。亞洲正好具備這種兼容性,既擁抱新科技,又追求實際應用價值,這和 XION 的理念很對路。

現在他們不僅想吸引用戶,更要吸引品牌、開發者和內容創作者,一起把生態做大。APAC 這場牌打得好,XION 不只是出海,而是有機會真正引爆全球 Web3 的下一波浪潮。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon @shoutdotfun $ENERGY 熱度也很高

查看原文創始人 Burnt Banksy 明確講了,這次不是簡單地做市場推廣,而是開啓一場多月的 APAC 行動計劃。從他在美股圈的活躍,到現在將重心轉向亞洲,說明 XION 真的是想借亞太這片土壤,把“讓加密消失”這個理念落地爲現實。

其實也不難理解。APAC 早就是新技術的試驗場,從三星、現代,到中國的基建和數字支付,這裏的用戶本身就更容易接受前沿科技。而在 Web3 領域,這裏更是佔了全球用戶的三分之二,有些國家加密持有率高達四分之一。

XION 想把 Web3 做到“像 Web2 一樣簡單”,那一定要從用戶習慣和文化出發。亞洲正好具備這種兼容性,既擁抱新科技,又追求實際應用價值,這和 XION 的理念很對路。

現在他們不僅想吸引用戶,更要吸引品牌、開發者和內容創作者,一起把生態做大。APAC 這場牌打得好,XION 不只是出海,而是有機會真正引爆全球 Web3 的下一波浪潮。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Aptos @0xPolygon @shoutdotfun $ENERGY 熱度也很高

- 讚賞

- 點讚

- 留言

- 分享

🫡 @TheoriqAI 在 @KaitoAI 的 Capital Launchpad 上開啓了社區輪,提前放出了 $THQ 的認購機會。這輪是 Pre-TGE 階段,算是官方第一次面向用戶放出代幣通道,而且是 7500 萬估值、TGE 全解鎖,超募了40倍,熱度直接拉滿了!!!

這次籌劃得很細,整個流程分成三步,先是“預留額度”,再是“優先認購”,最後還有“先到先得”。第一階段你要先鎖個定金,表明你想認多少;第二階段官方會發郵件告訴你有沒有拿到;第三階段是拼手速,沒搶到額度的用戶可以去撿漏。

對大部分人來說,關鍵是這次參與門檻還不高,在 Base 鏈上用 USDC pledge 就行,操作也不復雜。這輪還附帶了一個額外福利——只要參與了就能提前用上 AlphaSwarm 的 Beta 版本,也算是提前體驗 Theoriq 的核心產品。

其實從 Theoriq 之前一系列布局來看,他們做 Agentic Economy 是有章法的,這次融資節奏也挺克制,沒有漫天要價、也不鎖倉,說明項目方還是希望社區真能參與進來,而不是只搞一波短期拉升。

如果你本來就對 AI+DeFi 這個方向感興趣,現在這個社區輪可能是一個不錯的切入點,搶個資格,邊體驗 AlphaSwarm 邊觀察項目推進節奏,挺合適的。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Apto

查看原文這次籌劃得很細,整個流程分成三步,先是“預留額度”,再是“優先認購”,最後還有“先到先得”。第一階段你要先鎖個定金,表明你想認多少;第二階段官方會發郵件告訴你有沒有拿到;第三階段是拼手速,沒搶到額度的用戶可以去撿漏。

對大部分人來說,關鍵是這次參與門檻還不高,在 Base 鏈上用 USDC pledge 就行,操作也不復雜。這輪還附帶了一個額外福利——只要參與了就能提前用上 AlphaSwarm 的 Beta 版本,也算是提前體驗 Theoriq 的核心產品。

其實從 Theoriq 之前一系列布局來看,他們做 Agentic Economy 是有章法的,這次融資節奏也挺克制,沒有漫天要價、也不鎖倉,說明項目方還是希望社區真能參與進來,而不是只搞一波短期拉升。

如果你本來就對 AI+DeFi 這個方向感興趣,現在這個社區輪可能是一個不錯的切入點,搶個資格,邊體驗 AlphaSwarm 邊觀察項目推進節奏,挺合適的。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @Apto

- 讚賞

- 點讚

- 留言

- 分享

🫡 @Mira_Network 想換個思路來破局——與其讓AI自己說了算,不如搞一個系統,站在AI的“上層”,專門負責驗證AI說的到底對不對。現在大家都在說AI有多牛,但真正能落地的場景其實很有限。

說到底,AI目前最大的問題就是“不靠譜”——它能寫出看起來很有邏輯的內容,但你一細看,就發現裏面經常摻着假的。這種問題在聊天機器人裏還好,但一旦要應用到醫療、法律、金融這種高風險場景,就完全不行了。

AI爲什麼會這樣?一個核心原因是,它在“準確率”和“穩定性”之間總是無法兼顧。你想讓它輸出得更穩定,就要把訓練數據收得更幹淨,結果就容易引入偏見。反過來你想讓它更貼近真實世界、覆蓋更全面,就得放進很多衝突的信息,模型反而變得“說話不靠譜”,也就是容易幻覺。

這種方式有點像給AI裝一個“事實審核員”。AI先輸出內容,Mira再把這些內容拆解成一段段小的判斷,然後交給多個獨立模型來驗證,看這些結論是不是靠譜。多個模型達成共識後,再通過鏈上節點生成一個驗證報告,相當於打上“已查證”的標記。

這個方向很有意思,因爲它不是去改AI的“腦子”,而是給AI配了一個“監督系統”。如果這個系統真的跑得順,以後我們可能就能放心讓AI去做更復雜、更高風險的事情,比如自動寫合同、自動審代碼,甚至獨立決策。這才是真正的AI基礎設施。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @A

查看原文說到底,AI目前最大的問題就是“不靠譜”——它能寫出看起來很有邏輯的內容,但你一細看,就發現裏面經常摻着假的。這種問題在聊天機器人裏還好,但一旦要應用到醫療、法律、金融這種高風險場景,就完全不行了。

AI爲什麼會這樣?一個核心原因是,它在“準確率”和“穩定性”之間總是無法兼顧。你想讓它輸出得更穩定,就要把訓練數據收得更幹淨,結果就容易引入偏見。反過來你想讓它更貼近真實世界、覆蓋更全面,就得放進很多衝突的信息,模型反而變得“說話不靠譜”,也就是容易幻覺。

這種方式有點像給AI裝一個“事實審核員”。AI先輸出內容,Mira再把這些內容拆解成一段段小的判斷,然後交給多個獨立模型來驗證,看這些結論是不是靠譜。多個模型達成共識後,再通過鏈上節點生成一個驗證報告,相當於打上“已查證”的標記。

這個方向很有意思,因爲它不是去改AI的“腦子”,而是給AI配了一個“監督系統”。如果這個系統真的跑得順,以後我們可能就能放心讓AI去做更復雜、更高風險的事情,比如自動寫合同、自動審代碼,甚至獨立決策。這才是真正的AI基礎設施。

關鍵是它在 @KaitoAI 上有榜單活動, 最近 @arbitrum @A

- 讚賞

- 點讚

- 留言

- 分享